Me devuelvo para mi casa hago oficio, preparo el almuerzo, almuerzo . me arreglo y me voy para el sena a estudiar.

Este es un claro ejemplo de un lagoritmo en mi vida diaria.

Hace tiempo estoy tratando de buscar puntos en común entre programas que considero excelentes, siempre hablando desde el punto de vista del usuario, claro, ya que del lado del código son muy pocos los que pueden opinar (además de que pueden existir programas impecables de acuerdo a su código y completamente inusables). He aquí algunas que fuí anotando:

Un buen programa debe ser rápido: Puede tener o no un código optimizado, pero el usuario final debe sentir que para lo que usa el programa el tiempo que tarda en hacer las cosas es normal, un buen ejemplo es el reproductor multimedia Songbird, que puede ser excelente pero por lo que tarda en iniciar para los que solo quieren escuchar una canción lo convierten en una contra que le cava la tumba. Otro buen ejemplo son los visualizadores de imágenes, que deben ser instantáneos al abrir (como Irfanview). Por el otro lado programas profesionales como Autocad, 3Dstudio y demás pueden tardarse otro tiempo en abrir, para ellos tenemos otras pretensiones.

Un buen programa debe ser estable: Una fija es la confiabilidad que debe generar un programa, una buena aplicación no te debe dejar a mitad del camino con todo el trabajo hecho en un procesador de textos, con una cita a punto de concretarse mediante el programa de chat ni con una presentación frustrada delante de decenas de colegas. Y si falla (porque nade es perfecto en esta vida) un buen software debe tener tantas opciones de recuperación como sean posibles (recuperar últimas sesiones, mensajes offline, abrir el último archivo en el lugar donde quedamos, entre otras).

Un buen programa debe ser usable e intuitivo: De nada sirve que programes algo con miles opciones si no las colocas de una manera de que el usuario pueda encontrarlas y utilizarlas. Eso no quiere decir que las miles de opciones estén a la vista como las viejas versiones de Word que mareaban al pobre usuario de oficina. Lo ideal es presentar de una manera accesible los menúes frecuentes y luego juntar todos los demás en un menú avanzado para que, además, los usuarios que se inician con el software no sufran frustraciones tempranas y se vayan adecuando al mismo de una manera paulatina. El botón office fue uno de los primeros ejemplos de ello, que ahora sigue con todos los programas que usan Ribbon, el menú configuración avanzada de NOD es otro. Picasa es un ejemplo genial de usabilidad, tiene de todo, para todo, y se encuentra muy fácil.

Un buen programa debe actualizarse silenciosamente: No hay nada más placentero que ver que Mozilla nos avisa que actualizó a la última versión y que se instalará en el próximo reinicio. Este mismo programa a lo sumo requiere la acción del usuario para actualizar complementos de vez en cuando y es casi el extremo de programas molestísimos como Adobe Reader o Real Player que le preguntan al usuario hasta la hora.

Un buen programa debe ser inteligente: Quizás este punto parezca un poco pretencioso, pero hace unos días estaba hablando con un amigo de algunas características que tiene JDownloader, entre ellas el hecho de que si usas un password para descomprimir un archivo descargado, luego, al bajar otros archivos y en lugar de pedir passwords primero prueba descomprimirlo con los passwords anteriormente utilizados. Esto que parece una tontería (y debe ser sencillo de implementar) es una genial muestra de un programa que va aprendiendo a medida que uno lo va utilizando. Cuanta razón tienen los libros de usabilidad cuando afirman que los usuarios no quieren pensar, quieren todo servido, ya digerido.

El

Descripción del lenguaje de programación ada

Es el ultimo intento de obtener un único lenguaje para todo tipo de aplicaciones e incluye los últimos avances en técnicas de programación.

Su diseño fue encargado por el

La estandarización del lenguaje se publico en 1983 con el nombre de ADA, en honor a la primera programadora de la historia, Augusta Ada Byron.

Es un lenguaje estructurado parecido al PASCAL, destinado a controlar mecanismos en "tiempo real" (o sea una velocidad compatible con las necesidades reales), pero de gran complejidad. Admite una programación "orientada a objetos" y un sistema de alta modularidad de tipo hipertexto.

El ADA es un lenguaje grande que es relativamente difícil de compilar porque hace muchas comprobaciones en tiempo de compilación. Se ha estimado que un compilador de Ada completamente validado requiere cerca de 50 años de horas hombre para escribirlo y ponerlo a punto.

Características del Ada:

El lenguaje ha ido evolucionando hasta que en el año 1995 surgió la revisión llamada Ada9X (o Ada95). En el Ada95 se añadieron nuevas sentencias y la programación Orientada a Objeto. (Ver Apéndice A Figura 1 Evolución de Ada 95)

Los elementos teóricos de sistemas de computación

SISTEMA: Conjunto de partes interrelacionadas para lograr un objetivo en común, llamado objeto real.

CONCEPTO DE PROGRAMA:

Un programa es un conjunto de instrucciones que al ser ejecutadas resuelven un problema.

La computadora se utiliza para procesar en forma automática y a gran

Para procesar la información está el hardware (microprocesador, RAM,...), y el software (que sirve para

Un programa tiene 3 partes:

En la parte de las acciones a ejecutar se distinguirán dos partes:

ESQUEMA GENERAL (ver Apéndice figura 3)

Objeto Real: | |

Sistema:Conjunto de

| Base: Información estática de datos y archivos.

|

Medio Exterior: Sitios o condiciones con los que se relacionan y conecta el sistema. | |

ALGORITMOS

¿Qué es un algoritmo?:

Es una formula para resolver un problema. Es un conjunto de acciones o secuencia de operaciones que ejecutadas en un determinado orden resuelven el problema. Existen n algoritmos, hay que coger el más efectivo.

Es una secuencia ordenada de pasos - sin ambigüedades -, repetible, que es solución de un determinado problema.

Las características fundamentales que debe cumplir todo algoritmo son:

El algoritmo trata de resolver problemas mediante programas.

FASES:

3. Diseño del algoritmo: Diseñar la solución. Una vez comprendido el problema se trata de determinar que pasos o acciones tenemos que realizar para resolverlo.

Como criterios a seguir a la hora de dar la solución algorítmica hay que tener en cuenta:

Una segunda filosofía a la hora de diseñar algoritmos es el refinamiento por pasos, y es partir de una idea general e ir concretando cada vez más esa descripción hasta que tengamos algo tan concreto para resolver. Pasamos de lo más complejo a lo más simple.

La representación de los algoritmos:

Una vez que tenemos la solución hay que implementarla con alguna representación. Las representaciones más usadas son los flujogramas, los diagramas NS y el pseudocódigo.

4. Resolución en computadora: Implantación del algoritmo en un lenguajede programación.

5. Ejecución del programa, pruebas y mantenimiento: Ver si el programa hace lo que queríamos (dentro de procedimientos)

PROCEDIMIENTOS

Son los pasos que definen el empleo especifico de cada elemento del sistema o el contexto procedimental en que reside el sistema. Los sistemas basados en computadoras Intentan poner orden a un desarrollo de sistemas e intentan poner al software en su contexto por lo tanto establece enlaces que unen al software con los elementos de un sistema basado en computadoras. El papel del ingeniero de sistemas es definir los elementos de un sistema especifico basado en

En el proceso cada elemento se implementa especificando los componentes técnicos que dan funcionalidad necesaria a un elemento en el contexto software, un componente podría ser un programa de computadora, un componente de programa reutilizable, un modulo, una clase u objeto o incluso una sentencia de lenguaje de programación.

Llflf

Sintaxis y Semántica

Conceptos de Hardware y Software

Programas de computadoras (Computer software):

Un programa es una serie de instrucciones que le dice al equipo de computadora las tareas que debe realizar. La computadora realiza, o ejecuta, las instrucciones de un programa colocándolas primero (loading) en la memoria de la computadora. Cuando se compra un programa, se recibe en discos o CD. Algunos programas se cargan (load) a la memoria directamente. Otros deben instalarse en forma total o parcial en el disco duro (hard disk) de la computadora antes de poder usar el programa. Los programas de computadoras los podemos separar en dos tipos: Programas de sistemas (“System software”) y Programas de aplicaciones (“Application software”).

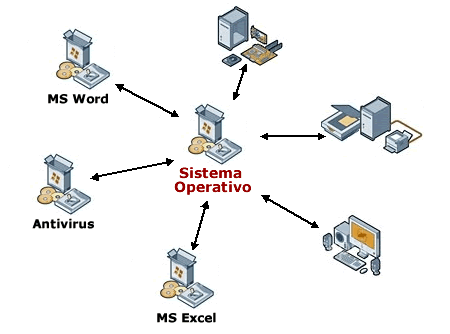

System Software

Consiste de los programas que controlan las operaciones de la computadora y sus equipos. Sirve como interfase entre el usuario, el programa de aplicación y el equipo de la computadora. El sistema operativo tiene la interfase del usuario, que es la forma en que se interacciona con los programas que están en la computadora. La interfase controla cómo se entran los datos e instrucciones, y cómo la información se presenta en la pantalla. Muchos programas actuales usan “Graphical User Interface” o GUI, en donde se interacciona con los programas usando imágenes visuales como iconos. Un icono es una imagen pequeña que representa un programa, una instrucción u otro objeto.

Hay dos tipos de programas de sistema: Sistema Operativos y Programas de Utilidades.

Sistemas Operativos

Programas con las instrucciones que coordinan todas las actividades entre el equipo de la computadora. También contienen instrucciones que permiten ejecutar o correr los programas de aplicaciones. Cuando la computadora se enciende, el sistema operativo es cargado a la memoria de la computadora.

Programas de Utilidades

Es un tipo de programa de sistema que ejecuta una tarea específica, usualmente relacionada a manejar la computadora, sus equipos o programas.

Application Software

Consiste de programas que realizan tareas específicas para los usuarios. Incluyen programas de procesadores de palabras (ejemplo: Word, WordPerfect), programas de hojas de cálculo (ejemplo: Excel, Lotus123) y programas de gráficas para presentaciones (ejemplo: PowerPoint, Presentation). Otros tipos de programas de aplicaciones son:

v Package Software – son programas con derechos de autor (copyright) que satisfacen las necesidades de una gran variedad de usuarios. Se pueden comprar en tiendas de computadoras o a través del Internet.

v Custom Software – programa desarrollado para realizar funciones específicas de un usuario o compañía. Por lo general son programas que atienden necesidades que no son satisfechas por software package.

v Freeware, Public-domain software, Shareware

§ Freeware – programa que una compañía o individuo provee libre de costo, a un usuario. Un programa freeware tiene derechos de autor, el usuario no puede venderlo.

§ Public-domain software – es un programa libre de costo que ha sido donado para uso público y no tiene restricciones de derecho de autor.

§ Shareware – es un programa con derechos de autor que es distribuido libre de costo por un periodo de prueba. Si se desea continuar utilizando el programa después del periodo de prueba, se envía el pago a la persona o compañía que lo desarrolló.

v Application Service Provider (ASP) – Es una compañía que maneja y distribuye programas y servicios en el Internet. En vez de que el usuario instale programas en su computadora, los programas se ejecutan desde el Internet. Algunos suplidores proveen acceso libre de costo, otros no.

Desarrollo de programas

Los programadores son las personas que escriben programas para las computadoras. Debe colocar las instrucciones en la secuencia correcta para que la computadora genere los resultados deseados. Cuando se escriben programas complejos para grandes empresas, los programadores siguen un plan desarrollado por un analista de sistemas. El analista diseña los programas, trabajando junto al usuario y al programador para determinar los resultados del programa.

Redes (networks) e Internet

Una red o “network” es un grupo de computadoras y equipo conectados entre sí a través de medios y equipos de comunicación. Cuando la computadora está conectada a una red, se dice que está en-línea (online). Las redes permiten que los usuarios compartan recursos, como equipos, programas, datos e información. Compartir los recursos ahorra tiempo y dinero.

Muchas organizaciones conectan sus computadoras y forman una red. Una red de área local (Local Area Network – LAN) es una red que conecta computadoras en un área geográfica limitada, como un salón de laboratorio, una oficina o un grupo de edificios. Una red de área amplia (Wide Area Network) es una red que cubre un área geográfica amplia, por ejemplo que conecta oficinas a través del país. La red más grande mundialmente es el Internet. El Internet es un grupo de redes mundiales que une millones de negocios, agencias de gobierno, instituciones educativas e individuos.

En el interior de un gabinete de computadora, veras cables y conectores llendo y viniendo de un lado a otro, Una cosa que hay que recordar es que cada computadora es distinta en cuanto a su interior se refiere. En algunas computadoras la tarjeta de video esta integrada a la tarjeta madre (motherboard) mientras que en otras computadoras, la tarjeta de video puede estar puesta en un conector PCI o AGP.

Veremos un vistazo general de los tipos de componentes internos de una computadora. Hay que recordar que el interior de una computadora varia de modelo a modelo.

Lista de Componentes Internos

Motherboard

CPU

BIOS

RAM

Tarjeta de Video

Tarjeta de Sonido (Opcional)

Tarjeta de Red (Opcional)

Unidades de Almacenamiento

Fuente de Poder

El motherboard es el corazón de la computadora. El motherboard (tarjeta madre) contiene los conectores para conectar tarjetas adicionales (también llamadas tarjetas de expansión por ejemplo tarjetas de video, de red, MODEM, etc.). Típicamente el motherboard contiene el CPU, BIOS, Memoria, interfaces para dispositivos de almacenamiento, puertos serial y paralelo aunque estos puertos ya son menos comunes por ser tecnología vieja ahora se utilizan mas los puertos USB, ranuras de expansión, y todos los controladores requeridos para manejar los dispositivos periféricos estándar, como el teclado, la pantalla de video y el dispositivo de disco flexible.

Al comprar un motherboard es indispensable que concuerde con el tipo de procesador que vamos a utilizar ya que los distintos procesadores utilizan un conector diferente, por lo tanto deben de hacer juego, también hay que asegurarse de que la velocidad del procesador y la memoria pueda ser manejado por el motherboard. Así que cuando compres un motherboard, procesador y memoria asegúrate de que sean compatibles entre sí.

Otro aspecto a considerar en el motherboard es que existen distintas tipos de formas de la tarjeta madre (form-factor), que definen como se conecta el motherboard al gabinete, los conectores para la fuente de poder y las características eléctricas. Hay bastantes formas de motherboard disponibles Baby AT, ATX, microATX y NLX. Hoy en día se consideran el Baby AT y el ATX como motherboards genéricos.

No se puede poner un motherboard ATX en un Gabinete baby AT, pero si puedes poner un motherboard baby AT y su fuente de poder en muchos Gabinetes ATX que tienen la preparación para montar ambos tipos de motherboard. Muchos motherboard recientes de forma baby AT traen conectores para corriente para los dos tipos de Fuentes de poder.baby AT y ATX. Lista de Componentes Internos.

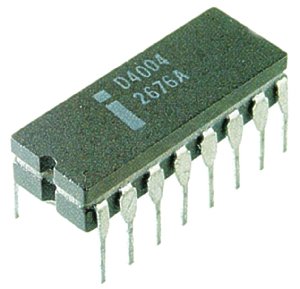

Es la abreviación de las siglas en ingles de las palabras Unidad Central de Procesamiento (central processing unit). El CPU es el cerebro de la computadora. Algunas veces se le dice simplemente el procesador o procesador central. El CPU es donde se realizan la mayoría de los cálculos. En términos de poder de computación, el CPU es el elemento más importante de un sistema de computo.

En computadoras personales y pequeños servidores, el CPU esta contenido en una pastilla llamada microprocesador.

Dos componentes típicos del CPU son:

La unidad lógica aritmética (ALU), la cual realiza las operaciones lógicas y matemáticas.

La unidad de control, la cual extrae instrucciones de la memoria la decodifica y ejecuta, llamando al ALU cuando es necesario.

Actualmente hay 2 productores principales de Procesadores, Intel y AMD.

Intel tiene 2 familias de procesadores, El Celeron para los equipos menos poderosos y el Pentium 4 para los mas poderosos con el Pentium 5 en camino.

AMD también tiene 2 familias de productos, El Duron para los equipos económicos y el Athlon para los mas poderosos.

Los CPU´s de Intel y AMD requieren un motherboard diseñado especialmente para ellos. El procesador determina el tipo de motherboard que necesitas para tu sistema.

En precio y rendimiento los CPU´s de Intel y AMD están muy parejos.

El rendimiento de un CPU generalmente se mide en ciclos de reloj por segundo. Entre mas alto los ciclos de reloj por segundo, es mas rápido el procesador, Aunque esto no siempre es verdad. Los procesadores AMD corren a menos ciclos de reloj por segundo que los CPU´s de Intel, pero siguen teniendo un rendimiento igual por el precio.

Esto se debe a que los procesadores AMD son mas eficientes por ciclo de reloj, Los ciclos de reloj por segundo se expresan en Giga Hertz. Un procesador que corre a 1 Giga Hertz es considerado de baja velocidad y un procesador que corre a 3 o mas Giga Hertz se considera de alta velocidad.

Los procesadores AMD usan un sistema de calificación basado en el rendimiento en vez de calificar solo la velocidad. Un procesador AMD calificado a 3200+ significa que tiene un rendimiento al mismo nivel que un CPU Pentium de 3200 MHZ o 3.2 GHZ.

Los procesadores también se califican por la velocidad a la cual se conectan al motherboard. Esto se llama velocidad FSB (Front Side Bus). Los procesadores de Intel pueden tener una velocidad hasta 800 MHz FSB y el AMD hasta 400 MHz FSB. Por eso te debes de asegurar que el motherboard soporte la velocidad FSB del procesador.

BIOS

Bios es un acrónimo de Basic input/output system (sistema básico de entrada / salida). El BIOS es el software que determina que puede hacer una computadora sin acceder programas de un disco. En las PCs, el BIOS contiene todo el código requerido para controlar el teclado, el monitor, las unidades de discos, las comunicaciones seriales, y otras tantas funciones.

El BIOS típicamente se pone en una pastilla ROM que viene con la computadora (también se le llama ROM BIOS. Esto asegura que el BIOS siempre estará disponible y no se dañara por falla en el disco. También hace posible que la computadora inicie por sí sola. A causa de que la RAM es más rápida que el ROM, muchos fabricantes de computadoras diseñan sistemas en los cuales el BIOS es copiado de la ROM a la RAM cada vez que la computadora es iniciada. Esto se conoce como shadowing.

Muchas computadoras modernas tienen Flash BIOS, que significa que el BIOS se grabo en una pastilla de memoria flash, que puede ser actualizado si es necesario.

RAM es acrónimo para random access memory (memoria de acceso aleatorio), es un tipo de memoria que puede ser accesado aleatoriamente; esto es, que cualquier byte de memoria puede ser accesado sin tocar los bytes predecesores. RAM es el tipo de memoria mas común encontrado en computadoras y otros dispositivos, como impresoras.

Hay dos tipos básicos de RAM

RAM dinámica (DRAM)

RAM estatica (SRAM)

Los 2 tipos difieren en la tecnología que utilizan para retener datos, el tipo mas común es la RAM dinámica. La RAM Dinámica necesita refrescarse miles de veces por segundo. La RAM estática no necesita ser refrescada, lo cual la hace mas rápida, pero también mas cara que la RAM dinámica. Ambos tipos de RAM son volátiles, ya que pierden su contenido cuando la energía es apagada.

Tarjeta de Video

La tarjeta de video, es el componente encargado de generar la señal de video que se manda a la pantalla de video por medio de un cable. La tarjeta de video se encuentra normalmente en integrado al motherboard de la computadora o en una placa de expansión. La tarjeta gráfica reúne toda la información que debe visualizarse en pantalla y actúa como interfaz entre el procesador y el monitor; la información es enviada a éste por la placa luego de haberla recibido a través del sistema de buses. Una tarjeta gráfica se compone, básicamente, de un controlador de video, de la memoria de pantalla o RAM video, y el generador de caracteres, y en la actualidad también poseen un acelerador de gráficos.

El controlador de video va leyendo a intervalos la información almacenada en la RAM video y la transfiere al monitor en forma de señal de video; el número de veces por segundo que el contenido de la RAM video es leído y transmitido al monitor en forma de señal de video se conoce como frecuencia de refresco de la pantalla. Entonces, como ya dijimos antes, la frecuencia depende en gran medida de la calidad de la placa de video.

Tarjeta de Sonido (Opcional)

- La mayoría de las tarjetas madre ahora cuentan con algún tipo de controlador de sonido integrado. Por lo tanto, las tarjetas de sonido no son necesarios a menos que quieras mayor fidelidad de sonido en tu computadora o liberar un poco de carga al CPU con el control del sonido.

Tarjeta de RED (Opcional)

- Estar en Red ya sea Internte o una Intranet es tan comun e indispensable que esta debería ser una característica estándar en todas las placas base. Algunas placas base, incluso, ofrecen adaptadores de red inalámbrica construido adentro Si la placa no tiene un conector Ethernet, puede ser necesario instalar una tarjeta PCI Ethernet o tal vez una tarjeta inalámbrica 802.11.

Unidades de Almacenamiento

Refiriéndonos a varias técnicas y dispositivos para almacenar grandes cantidades de datos. Los primeros dispositivos de almacenamiento fueron las tarjetas perforadas, que fueron usadas desde el año 1804 en maquinas tejedoras de ceda. Los dispositivos modernos de almacenamiento incluyen todo tipos de unidades de disco y de unidades de cinta. Almacenamiento masivo es distinto al de memoria, que se refiere a almacenamiento temporal, en cambio los dispositivos de almacenamiento masivo retienen los datos aun cuando la computadora es apagada.

Los tipos principales de dispositivos de almacenamiento masivo son:

Discos flexibles (disquetes): Relativamente lentos y pequeña capacidad, pero muy portables, baratos y universales (casi obsoletos, las computadoras nuevas ya no los utilizán)

Discos Duros:

rápidos y mucho mayor capacidad, pero más caros, Algunos dispositivos de disco duro son portátiles pero la mayoría no.

Discos Ópticos: (conocidos como CDs y DVD´s) al contrario de los discos flexibles y los discos duros, los cuales usan electromagnetismo para codificar los datos, los sistemas de discos ópticos usan un láser para leer y escribir datos. Los discos ópticos tienen buena capacidad, pero no son tan rápidos como los discos duros. Y por lo general son de solo lectura, aunque también hay reescribibles.

Cintas: Relativamente baratas y pueden tener una gran capacidad, pero no permiten acceso aleatorio a los datos.

Discos de memoria Flash USB:

( Jumpdrives, Pocket Drives, Pen Drives, thumb drives) dispositivos muy pequeños, ligeros y portátiles pueden almacenar hasta 2gb de datos estos dispositivos se han vuelto muy populares y están sustituyendo a los discos flexibles al tener mayor capacidad y velocidad, estos dispositivos pueden mantener la información hasta por 10 años.

Fuente de Poder

La fuente de poder es el componente que proporciona el poder eléctrico a la computadora. La mayoría de las computadoras pueden conectarse a un enchufe eléctrico estándar. La fuente de poder jala la cantidad requerida de electricidad y la convierte la corriente AC a corriente DC. También regula el voltaje para eliminar picos y crestas comunes en la mayoría de los sistemas eléctricos. Pero no todas las fuentes de poder, realizan el regulado de voltaje adecuadamente, así que una computadora siempre esta susceptible a fluctuaciones de voltaje.

Las fuentes de poder se califican en términos de los watts que generan. Entre más poderosa sea la computadora, mayor cantidad de watts necesitan sus componentes.

Máquina capaz de efectuar una secuencia de operaciones mediante un programa, de tal manera, que se realice un procesamiento sobre un conjunto de datos de entrada, obteniéndose otro conjunto de datos de salida.

TIPOS DE COMPUTADORAS

Se clasifican de acuerdo al principio de operación de Analógicas y Digitales.

HISTORIA DE LA COMPUTACIÓN

Uno de los primeros dispositivos mecánicos para contar fue el ábaco, cuya historia se remonta a las antiguas civilizaciones griega y romana. Este dispositivo es muy sencillo, consta de cuentas ensartadas en varillas que a su vez están montadas en un marco rectangular. Al desplazar las cuentas sobre varillas, sus

Otro de los inventos mecánicos fue la Pascalina inventada por Blaise Pascal (1623 - 1662) de Francia y la de Gottfried Wilhelm von Leibniz (1646 - 1716) de Alemania. Con estas máquinas, los datos se representaban mediante las posiciones de los engranajes, y los datos se introducían manualmente estableciendo dichas posiciones finales de las

La primera computadora fue la máquina analítica creada por Charles Babbage, profesor matemático de la Universidad de Cambridge en el siglo XIX. La idea que tuvo Charles Babbage sobre un computador nació debido a que la elaboración de las tablas matemáticas era un proceso tedioso y propenso a errores. En 1823 el gobierno Británico lo apoyo para crear el proyecto de una máquina de diferencias, un dispositivo mecánico para efectuar sumas repetidas.

Mientras tanto Charles Jacquard (francés), fabricante de tejidos, había creado un telar que podía reproducir automáticamente patrones de tejidos leyendo la información codificada en patrones de agujeros perforados en tarjetas de papel rígido. Al enterarse de este método Babbage abandonó la máquina de diferencias y se dedico al proyecto de la máquina analítica que se pudiera programar con tarjetas perforadas para efectuar cualquier cálculo con una precisión de 20 dígitos. La tecnología de la época no bastaba para hacer realidad sus ideas.

El mundo no estaba listo, y no lo estaría por cien años más.

En 1944 se construyó en la

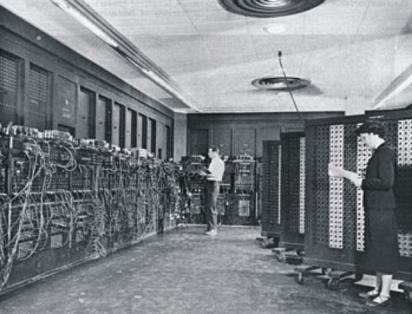

En 1947 se construyó en la Universidad de Pennsylvania la ENIAC (Electronic Numerical Integrator And Calculator) que fue la primera computadora electrónica, el equipo de diseño lo encabezaron los ingenieros John Mauchly y John Eckert. Esta máquina ocupaba todo un sótano de la Universidad, tenía más de 18 000 tubos de vacío, consumía 200 KW de energía eléctrica y requería todo un sistema de aire acondicionado, pero tenía la capacidad de realizar cinco mil operaciones aritméticas en un segundo.

El proyecto, auspiciado por el

La EDVAC (Electronic Discrete Variable Automatic Computer) fue diseñada por este nuevo equipo. Tenía aproximadamente cuatro mil bulbos y usaba un tipo de memoria basado en tubos llenos de mercurio por donde circulaban señales eléctricas sujetas a retardos.

La idea fundamental de von Neumann fue: permitir que en la memoria coexistan datos con instrucciones, para que entonces la computadora pueda ser programada en un lenguaje, y no por medio de alambres que eléctricamente interconectaban varias secciones de control, como en la ENIAC.

Todo este desarrollo de las computadoras suele divisarse por generaciones y el criterio que se determinó para determinar el cambio de generación no está muy bien definido, pero resulta aparente que deben cumplirse al menos los siguientes requisitos:

Primera Generación

En esta generación había una gran desconocimiento de las capacidades de las computadoras, puesto que se realizó un

Esta generación abarco la década de los cincuenta. Y se conoce como la primera generación. Estas máquinas tenían las siguientes características:

En esta generación las máquinas son grandes y costosas (de un costo aproximado de ciento de miles de dólares).

En 1951 aparece la UNIVAC (NIVersAl Computer), fue la primera computadora comercial, que disponía de mil palabras de memoria central y podían leer cintas magnéticas, se utilizó para procesar el censo de 1950 en los Estados Unidos.

En las dos primeras generaciones, las unidades de entrada utilizaban tarjetas perforadas, retomadas por Herman Hollerith (1860 - 1929), quien además fundó una compañía que con el paso del tiempo se conocería como IBM (International Bussines Machines).

Después se desarrolló por IBM la IBM 701 de la cual se entregaron 18 unidades entre 1953 y 1957.

Posteriormente, la compañía Remington Rand fabricó el modelo 1103, que competía con la 701 en el campo científico, por lo que la IBM desarrollo la 702, la cual presentó problemas en memoria, debido a esto no duró en el mercado.

La computadora más exitosa de la primera generación fue la IBM 650, de la cual se produjeron varios cientos. Esta computadora que usaba un esquema de memoria secundaria llamado tambor magnético, que es el antecesor de los discos actuales.

Otros modelos de computadora que se pueden situar en los inicios de la segunda generación son: la UNIVAC 80 y 90, las IBM 704 y 709, Burroughs 220 y UNIVAC 1105.

Segunda Generación

Cerca de la década de 1960, las computadoras seguían evolucionando, se reducía su tamaño y crecía su capacidad de procesamiento. También en esta época se empezó a definir la forma de comunicarse con las computadoras, que recibía el nombre de programación de sistemas.

Las características de la segunda generación son las siguientes:

En esta generación las computadoras se reducen de tamaño y son de menor costo. Aparecen muchas compañías y las computadoras eran bastante avanzadas para su época como la serie 5000 de Burroughs y la

Algunas de estas computadoras se programaban con cintas perforadas y otras más por medio de cableado en un tablero. Los programas eran hechos a la medida por un equipo de expertos: analistas, diseñadores, programadores y operadores que se manejaban como una orquesta para resolver los problemas y cálculos solicitados por la administración. El usuario final de la información no tenía contacto directo con las computadoras. Esta situación en un principio se produjo en las primeras computadoras personales, pues se requería saberlas "programar" (alimentarle instrucciones) para obtener resultados; por lo tanto su uso estaba limitado a aquellos audaces pioneros que gustaran de pasar un buen número de horas escribiendo instrucciones, "corriendo" el programa resultante y verificando y corrigiendo los errores o bugs que aparecieran. Además, para no perder el "programa" resultante había que "guardarlo" (almacenarlo) en una grabadora de astte, pues en esa época no había discos flexibles y mucho menos discos durospara las

El usuario de las computadoras va cambiando y evolucionando con el tiempo. De estar totalmente desconectado a ellas en las máquinas grandes pasa la PC a ser pieza clave en el diseño tanto del hardware como del software. Aparece el concepto de human interface que es la relación entre el usuario y su computadora. Se habla entonces de hardware ergonómico (adaptado a las dimensiones humanas para reducir el cansancio), diseños de pantallas antirreflejos y teclados que descansen la muñeca. Con respecto al

Las computadoras de esta generación fueron: la Philco 212 (esta compañía se retiró del mercado en 1964) y la UNIVAC M460, la Control Data Corporation modelo 1604, seguida por la serie 3000, la IBM mejoró la 709 y sacó al mercado la 7090, la National Cash Register empezó a producir máquinas para proceso de datos de tipo comercial, introdujo el modelo NCR 315.

La Radio Corporation of

Tercera generación

Con los progresos de la electrónica y los avances de comunicación con las computadoras en la década de los 1960, surge la tercera generación de las computadoras. Se inaugura con la IBM 360 en abril de 1964.3

Las características de esta generación fueron las siguientes:

La IBM produce la serie 360 con los modelos 20, 22, 30, 40, 50, 65, 67, 75, 85, 90, 195 que utilizaban técnicas especiales del procesador, unidades de cinta de nueve canales, paquetes de discos magnéticos y otras características que ahora son estándares (no todos los modelos usaban estas técnicas, sino que estaba dividido por aplicaciones).

El sistema operativo de la serie 360, se llamó OS que contaba con varias configuraciones, incluía un conjunto de técnicas de manejo de memoria y del procesador que pronto se convirtieron en estándares.

En 1964 CDC introdujo la serie 6000 con la computadora 6600 que se consideró durante algunos años como la más rápida.

En la década de 1970, la IBM produce la serie 370 (modelos 115, 125, 135, 145, 158, 168). UNIVAC compite son los modelos 1108 y 1110, máquinas en gran escala; mientras que CDC produce su serie 7000 con el modelo 7600. Estas computadoras se caracterizan por ser muy potentes y veloces.

A finales de esta década la IBM de su serie 370 produce los modelos 3031, 3033, 4341. Burroughs con su serie 6000 produce los modelos 6500 y 6700 de avanzado diseño, que se reemplazaron por su serie 7000. Honey - Well participa con su computadora DPS con varios modelos.

A mediados de la década de 1970, aparecen en el mercado las computadoras de tamaño mediano, o minicomputadoras que no son tan costosas como las grandes (llamadas también como mainframes que significa también, gran sistema), pero disponen de gran capacidad de procesamiento. Algunas minicomputadoras fueron las siguientes: la PDP - 8 y la PDP - 11 de Digital Equipment Corporation, la VAX (Virtual Address eXtended) de la misma compañía, los modelos NOVA y ECLIPSE de Data General, la serie 3000 y 9000 de Hewlett - Packard con varios modelos el 36 y el 34, la Wang y Honey - Well -Bull, Siemens de origen alemán, la ICL fabricada en Inglaterra. En la Unión Soviética se utilizó la US (Sistema Unificado, Ryad) que ha pasado por varias generaciones.

Cuarta Generación

Aquí aparecen los microprocesadores que es un gran adelanto de la microelectrónica, son circuitos integrados de alta densidad y con una velocidad impresionante. Las microcomputadoras con base en estos circuitos son extremadamente pequeñas y baratas, por lo que su uso se extiende al mercado industrial. Aquí nacen las computadoras personales que han adquirido proporciones enormes y que han influido en la sociedAd en general sobre la llamada "revolución informática".

En 1976 Steve Wozniak y Steve Jobs inventan la primera microcomputadora de uso masivo y más tarde forman la compañía conocida como la Apple que fue la segunda compañía más grande del mundo, antecedida tan solo por IBM; y esta por su parte es aún de las cinco compañías más grandes del mundo.

En 1981 se vendieron 800 00 computadoras personales, al siguiente subió a 1 400 000. Entre 1984 y 1987 se vendieron alrededor de 60 millones de computadoras personales, por lo que no queda duda que su impacto y penetración han sido enormes.

Con el surgimiento de las computadoras personales, el software y los sistemas que con ellas de manejan han tenido un considerable avance, porque han hecho más interactiva la comunicación con el usuario. Surgen otras aplicaciones como los procesadores de palabra, las hojas electrónicas de cálculo, paquetes gráficos, etc. También las industrias del Software de las computadoras personales crece con gran rapidez, Gary Kildall y William Gates se dedicaron durante años a la creación de sistemas operativos y métodos para lograr una utilización sencilla de las microcomputadoras (son los creadores de CP/M y de los productos de Microsoft).

No todo son microcomputadoras, por su puesto, las minicomputadoras y los grandes sistemas continúan en desarrollo. De hecho las máquinas pequeñas rebasaban por mucho la capacidad de los grandes sistemas de 10 o 15 años antes, que requerían de instalaciones costosas y especiales, pero sería equivocado suponer que las grandes computadoras han desaparecido; por el contrario, su presencia era ya ineludible en prácticamente todas las esferas de control gubernamental, militar y de la gran industria. Las enormes computadoras de las

Quinta Generación